Microsoft ha fatto uso negli ultimi anni della tecnologia FPGA (field-programmable gate arrays), per incrementare le performance e l’efficienza di Bing e Azure.

Gli FPGA consistono in dei circuiti integrati con funzionalità programmabili via software. Tali dispositivi consentono l’implementazione di funzioni logiche anche molto complesse. Questo tipo di tecnologia ha assunto un ruolo sempre più importante nell’elettronica industriale così come nella ricerca scientifica. Grazie al continuo progredire delle tecniche di miniaturizzazione, le capacità di tali dispositivi sono aumentate enormemente nel corso di due soli decenni, durante i quali si è passati da poche migliaia di porte logiche a qualche milione di porte logiche per singolo dispositivo FPGA.

Microsoft starebbe pianificando per il 2018 di rendere disponibili tali processori FPGA direttamente agli sviluppatori, i quali saranno in grado di utilizzare tale tecnologia nell’ambito del proprio lavoro, specialmente nel campo dell’intelligenza artificiale (IA), come ad esempio il deep-neural-networking (DNN).

Alla Build Conference di Microsoft, tenutasi in questa primavera, il Direttore Tecnico di Azure, Mark Russinovich, ha delineato i programmi imminenti di Microsoft per la distribuzione di Hardware Microservices (microservizi hardware), tramite il cloud di Azure. Russinovich ha precisato ai partecipanti, una volta che Microsoft avrà risolto alcuni problemi di protezione supplementari:

Avremo quello che noi riteniamo essere un cloud completamente configurabile. Questo è il nucleo di un cloud con IA, un importante passo in avanti verso la democratizzazione dell’intelligenza artificiale attraverso le potenzialità dell’hardware FPGA.

Gli FPGA sono dei chip la cui programmazione può essere customizzata a seguito della loro fabbricazione. La ricerca Microsoft nell’ambito degli FPGA viene svolta regolarmente già da più di un decennio. Più di recente, Microsoft ha aggiunto gli FPGA a tutti i server e i datacenter di Azure e inoltre ha implementato tali chip in numerosi hardware che alimentano i server di indicizzazione di Bing, il tutto nell’ambito del più ampio progetto chiamato Project Catapult. Inoltre, Microsoft ha reso disponibile un servizio di Accelerating Networking per Azure, disponibile pubblicamente per Windows e in anteprima per Linux, che ugualmente fa uso di tecnologia FPGA.

Alla Build Conference nel mese di maggio, Russinovich affermò che Microsoft non aveva un calendario ben preciso sul rilascio degli Hardware Microservices e degli FPGA agli utenti. Ma questa settimana abbiamo avuto modo di apprendere dai funzionari Microsoft che tutto ciò verrà attuato in qualche mese del 2018.

Gli Hardware Microservices di Microsoft saranno installati direttamente sui chip FPGA prodotti da Intel (quest’ultima ha acquistato nel 2015 il produttore di FPGA, Altera). Tali chip, in coppia con i framework di Microsoft, forniranno numerosi vantaggi in velocità, efficienza e latenza, caratteristiche che si adattano particolarmente all’elaborazione di grandi moli di dati.

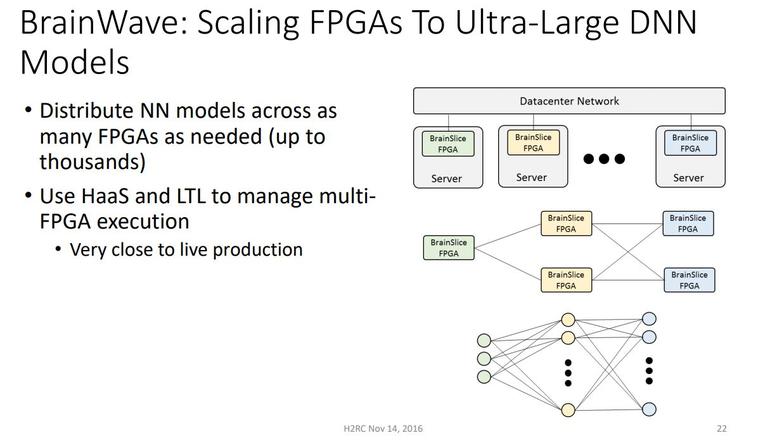

Il colosso di Redmond sta inoltre lavorando sul campo DNN – deep-neural-networking (che consiste in una tipologia di programmazione, ispirata alla biologia, che sviluppa macchine in grado di apprendere informazioni dai dati empirici), attraverso il progetto con il nome in codice BrainWave.

Microsoft ha reso pubblico il progetto BrainWave alla conferenza Ignite 2016 e in quella occasione ha fatto utilizzo di un chip FPGA per dimostrare come questo si comportasse di fronte a una grande mole di lingue da tradurre. I funzionari Microsoft avevano fino a poco tempo fa in agenda l’obiettivo di parlare nuovamente del progetto BrainWave a Redmond, al recente Faculty Research Summit interamente dedicato all’intelligenza artificiale. Ma a quanto si apprende dagli ultimi programmi in calendario dell’azienda, sembrerebbe che tutti i richiami a BrainWave per ora siano stati rimossi.

BrainWave è una piattaforma di deep-learning che gira sugli Hardware Microservices di Microsoft basati sugli FPGA. Così li ha definiti Microsoft nella conferenza del 2016, dedicata ai suoi piani futuri sul cloud configurabile, in cui parlava di Hardware Acceleration as a Service (accelerazione hardware come servizio), attraverso i datacenter sparsi per la rete.

Microsoft non è l’unica compagnia che sta lavorando ai chip FPGA per i suoi datacenter. Anche Amazon e Google stanno facendo utilizzo di silicio per personalizzare i loro chip nel campo dell’IA. Amazon ha già fornito un hardware development kit agli sviluppatori per gli FPGA, mentre Google sta lavorando all’addestramento di modelli di deep-learning tramite il software di machine-learning di nome TensorFlow, e ha anche sviluppato il suo chip Tensor Processing Unit, in silicio.

Articolo di Windows Blog Italia

Fonte | ZDNet